投稿

日程

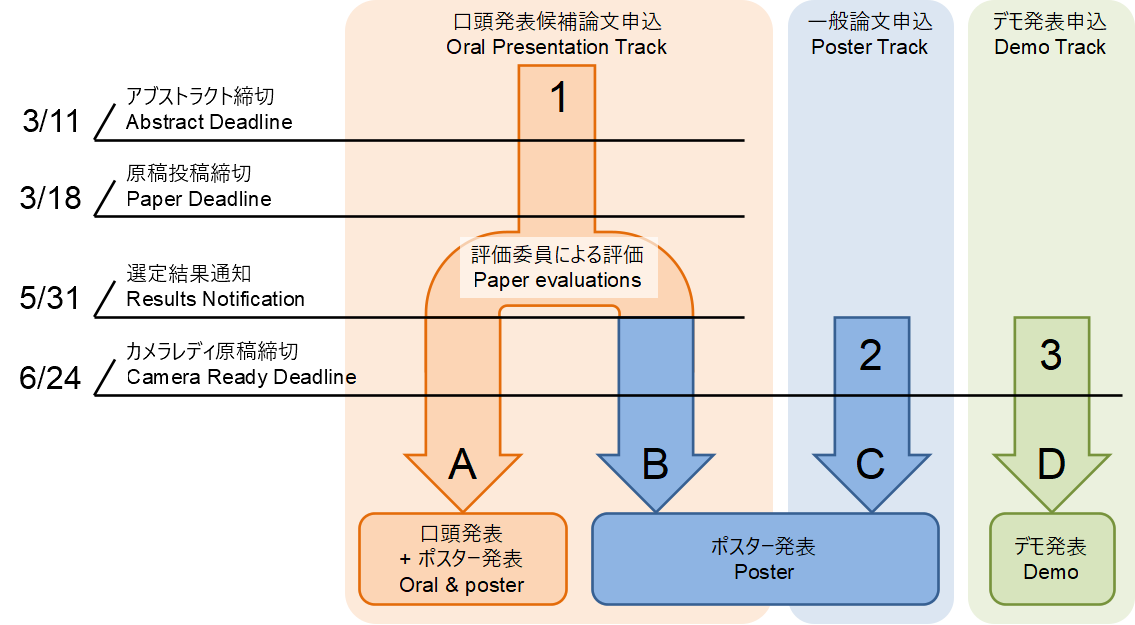

- 2024年2月2日(金):CMT投稿サイトオープン、口頭発表候補論文の受付開始

- 2024年3月11日(月):口頭発表候補論文 アブストラクト締切

- 2024年3月18日(月):口頭発表候補論文 投稿締切

- 2024年5月27日(月):一般論文投稿受付開始

- 2024年5月31日(金):口頭発表 結果通知(予定)

- 2024年6月24日(月):カメラレディ原稿提・サムネイル画像出締切(口頭発表候補論文・一般論文・デモ発表)・企業展示申込締切

- 2024年7月31日(水):Extended Abstract集公開

- 2024年8月6日(火)〜9日(金):シンポジウム開催

発表申し込み区分

- 口頭発表候補論文として投稿された論文は、評価委員によって評価されます。その結果、口頭発表に選定された論文は「発表区分A」の口頭発表とポスター発表となります。口頭発表に選定されなかった論文は、「発表区分B」のポスター発表となります。「発表区分C」との区別はありません。いずれの場合もカメラレディ原稿の締切は6/24です。

- 一般論文として投稿された論文は、「発表区分C」のポスター発表となります。一般論文の投稿締め切りは6/24です。

- ポスターとともに補助的に用いるノートパソコン・タブレット等を超える機材を使用したい場合(カメラやその他センサの利用、治具等の設置)は、「発表区分D」のデモ発表にお申し込み下さい。ポスターを貼付するパネルに加え、机の提供や電源の供給を受けることができます。発表申し込み時には、デモ論文を同時に投稿ください。デモの発表の申し込み締め切りは6/24です。

原稿作成要領・テンプレート

- 日本語または英語で原稿を作成して下さい。

- ページ数は4ページ以下(参考文献を除く)としてください。

- 概要(日本語原稿の場合200文字以下、英語原稿の場合100 words以下)を1ページ目に記載して下さい。

- 著者名と所属を原稿に明記して下さい。口頭発表候補論文の評価方法はシングルブラインド(著者名を評価委員に開示する方式)となります。

- (3/5追記)ビデオ、証明、コード、図表、実験のより詳細な分析など、補足資料を任意で提出することができます。ただし、補足資料の内容が評価に反映される保証はありませんのでご留意ください。

原稿テンプレート

原稿の作成には以下のスタイルファイルをご利用ください(昨年と異なりますのでご注意下さい)。

サムネイル画像【6/21更新】

- サムネイル画像は、BMVC2020のような形でEA集(予稿集)に使用します。

- サイズは幅484 x 高さ260 ピクセルとしてください。

- ファイルサイズの上限は300K byteとします。

- ファイル形式はjpgでお願いします。

その他

- 原稿の著作権は著者に帰属します。なお、MIRU Extended Abstract集はMIRU参加者にのみweb経由でMIRU期間中に公開します。

- カメラレディ原稿提出以降のタイトル・著者情報の変更はできませんのでご注意ください。

関連発表の有無に関する投稿ルール(二重投稿規程)

| 口頭発表候補論文 | 一般論文 | ||

|---|---|---|---|

| MIRU2024投稿締切時点で関連既発表あり、または掲載予定 | 関連既発表論文が査読付き | × | ○ |

| 関連既発表論文が査読なし(研究会、arXivなど) | ○ | ○ | |

| 他の査読付き国際会議等に関連論文を投稿中、または査読期間に重複有り | ○ | ○ | |

| 関連発表無し | ○ | ○ | |

(以下は口頭発表候補論文のみ対象です)

- MIRU はジャーナル論文・国際会議未満の「新しいアイディア」の交換の場であるという趣旨を鑑み、査読付きの既発表がある研究については投稿をご遠慮ください。

- MIRU2024 Extended Abstract集は非公開です。ただし、同じ内容もしくは一部を国際会議、ジャーナル等へ投稿している場合や今後予定している場合には、先方の投稿規定に抵触しないよう注意して下さい。

【参考】CVPR2024、ECCV2024では、参考文献を除き4ページ以下の論文は二重投稿規程に抵触しないとされています。

投稿方法

投稿はCMT(https://cmt3.research.microsoft.com/MIRU2024)で受け付けます。CMTの使い方は下記スライドを参照してください。

口頭発表論文の場合

一般論文の場合

デモ論文の場合

募集分野

領域A:幾何学的解析,光学的解析,3次元解析 | Area A: Geometric analysis, optical analysis, 3D analysis

- Camera, geometry, and photometry

- Computational imaging

- Physics-based vision and graphics

- Registration, pose estimation, and tracking

- 3D from a single image and shape-from-x

- 3D shape modeling, processing, and synthesis

- 3D from multi-view and sensors

領域B:パターン認識,機械学習,深層学習 | Area B: Pattern recognition, machine learning, deep learning

- Datasets, training, and evaluation

- Deep learning (architectures, generative models, deep reinforcement learning, geometric deep learning, etc.)

- General machine learning (active learning, clustering, online learning, ranking, reinforcement learning, un/semi/self-supervised learning, time series analysis, etc.)

- Learning theory (Bayesian methods, graphical models, statistical learning theory, etc.)

- Optimization (convex / non-convex optimization, matrix / tensor methods, stochastic, online, non-smooth, composite, etc.)

- Representation learning and feature extraction

- Transfer, low-shot, continual, and long-tail learning

- Trustworthy machine learning (accountability, causality, fairness, privacy, robustness, etc.)

領域C:画像/映像/マルチメディア処理 | Area C: Image/video/multimedia processing

- Action and event understanding

- Categorization, segmentation, and shape analysis

- Image / video analysis, retrieval, and understanding

- Image / video synthesis

- Low-level vision and signal processing

- Multimedia

- Object detection, matching, and tracking

- Vision and language

領域D:応用 | Area D: Application

- Autonomous driving and ITS

- Biometrics

- Cloud, web, and social media

- Document analysis and understanding

- Efficient, scalable, and realtime processing

- Human sensing (faces, gestures, pose, shape, etc.)

- Industry and manufacturing

- Life (sports, agriculture / forestry / fishery, civil engineering, commerce, fashion, food, home, etc.)

- Medical / biological vision and cell microscopy

- Robot vision and embodied vision

- Scene analysis and understanding

- XR and HCI